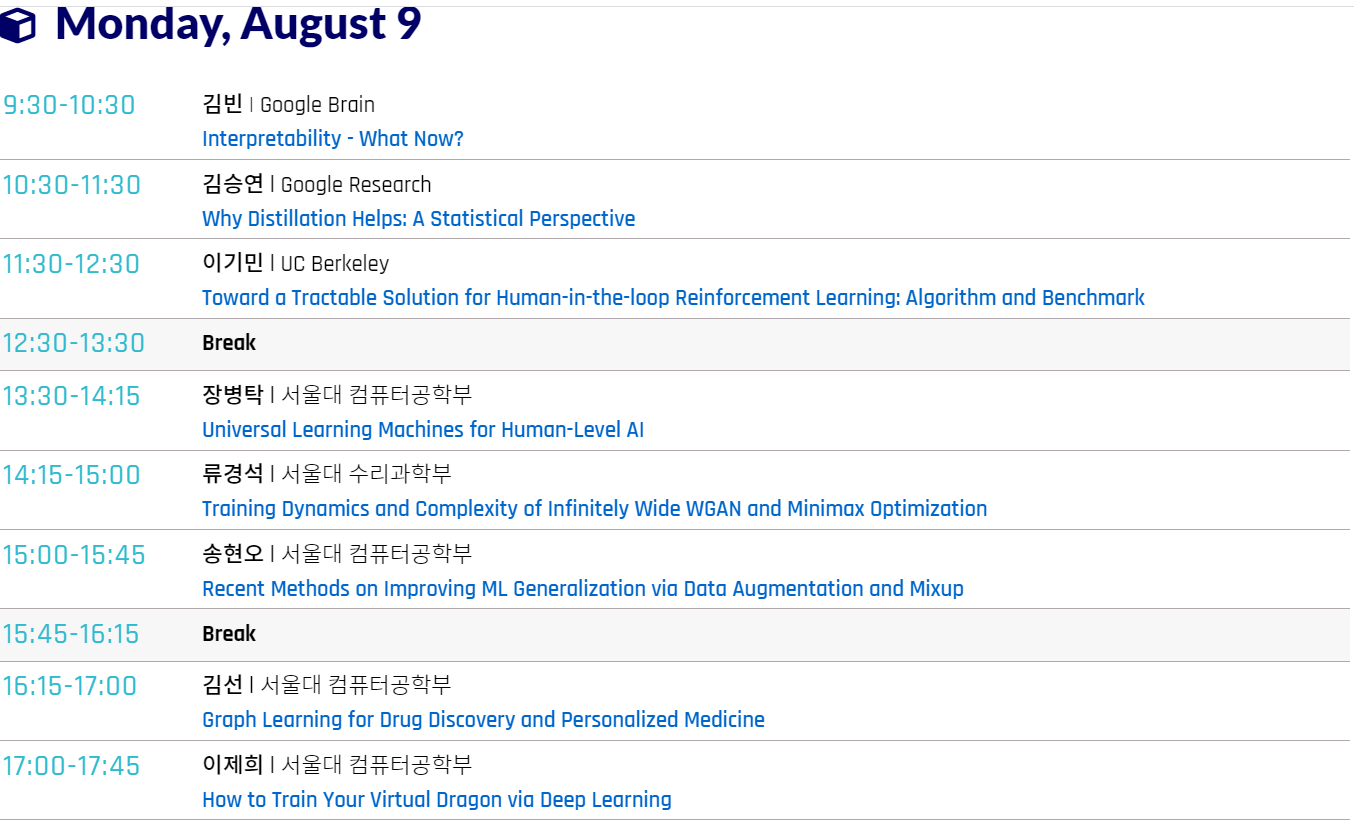

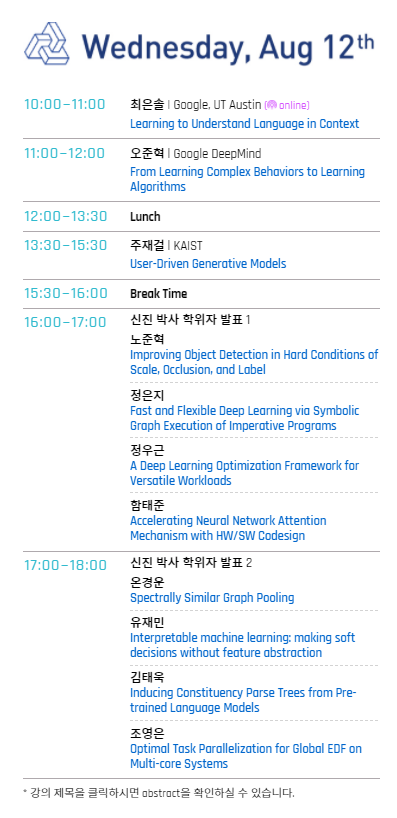

아쉽지만 오늘 (08/03/22)을 기준으로 3일 동안 열린 서울대학교 AI 여름학교는 마무리 되었습니다. 2020년 처음 개최를 시작으로 매년 여름마다 청취를 하며 새로운 연구에 대하여 접하고 지식을 차곡차곡 쌓아가는 시간을 가질 수 있었습니다. 매년 프로그램이 진행될 때 마다 다른 시도를 계속 반영하며 발전되는 점 또한 고무적이었고 무엇보다도 서울대학교 학생뿐만이 아닌 대중에게도 open되는 연구의 장이었던 점이 정말 값진 경험이라고 생각이 듭니다. 2020년에는 코로나로 인한 많은 변화가 시작된 시기 였지만 대면 참석을 하면서 들었습니다. 이후에는 하이브리드 형식으로 대면, 비대면 공동 진행이 되어 보다 쾌적하고 익숙한 환경에서 제약없이 들을 수 있던 점이 좋았습니다.

오늘 진행되었던 연구 세미나 중 이목을 끌었던 내용들은 math & statistical한 접근을 이용한 연구들 이었습니다. 그 중에서도 김지수 박사님께서 발표해주신 "Statistical inference on Topological Data Analysis and Application to Machine Learning"이란 주제는 topology(위상수학)을 기반으로 진행된 연구였습니다. 사실 일상 생활에서 topological의 구조는 쉽게 찾아볼 수 있습니다. 이는 미술관에서 흔히 관람할 수 있는 미술 작품에서도 찾아볼 수 있는데, 그림 작품 중 점묘법으로그려진 작품 중 점들을 topological structure 중 하나라는 것으로 이해하였습니다. 위상수학 자체가 난해한 학문이기에 이해가 쉽지 않았지만 여러모로 흥미롭게 들을 수 있었던 연구 였습니다.

개인적으로 최근에는 XAI 분야를 관심있게 보고 있는데, 오늘 "Scalable Trustworthy AI"의 주제로 발표를 나누어주신 오승준 교수님의 강의 시간을 통해 다른 시각으로도 생각을 해볼 수 있었습니다. 본래 딥러닝 모델은 black box nature를 가지고 있어서 어떠한 근거와 이유를 통하여 결과를 도출했는지 알기 쉽지 않습니다. 본 연구 내용에서는 What에서 How로 전환되는 과정을 설명해 주셨습니다. 여기에서 핵심은 첫 번째 발표에서 Emre kiciman에서 나누어주신 causality가 발표의 핵심 중 하나인 것을 알 수 있었습니다. 보통 기존의 머신 러닝은 p(x,y)를 통해 답을 도출하는데 본 발표에서는 p(x,y,z)를 기반으로 (x,y)데이터의 답을 도출하는 과정을 예를 들었습니다. 발표를 청취 중에 CALM에서 score map의 mechanism이 제일 인상적이였는데 논문 밑 코드를 다시 참고하여 공부를 해야겠다는 생각이 들었습니다.

이번 년도 작년과 다름없이 무료로 양질과 열정이 담긴 연구 세미나를 개최 해주셔서 감사합니다. 이전과 비교하였을 때 프로그램 전체가 영어로 진행이 되어서 듣는데 영어능력 또한 향상시킬 수 있었던 갔습니다. 외국에서도 여러 연구자들이 본 AI 여름학교를 수강하며 연구에 대한 토론의 장이 열리면 좋을 것 같다는 생각도 들었습니다.

3일 동안 세미나를 들으면서 부족하거나 처음 접했던 연구들도 검색 후 공부를 통하여 견문을 넓힐 수 있었으며, 쉽게 지나쳤던 부분들에 대해서도 한 번 다시 되돌아보면서 연구가 무엇인지에 대해서도 기본을 충실히 다시 되새김질할 수 있었던 시간 이였습니다.

마지막으로 연구 내용을 나누어주신 모든 연사님들과 저도 생각하지 못했던 질문해주신 청취자들, 그리고 프로그램을 기획하시고 운영하신 모든 분들의 노고에 항상 감사드립니다.